Robot humanoïde

Dans les films de science-fiction, il est courant de tomber sur un robot humanoïde. Il s’agit d’un robot regroupant plusieurs caractéristiques humaines. Cela peut aller de la simple bipédie jusqu’aux traits les plus fins d’un visage et même sa pilosité !

Dans Star Wars, par exemple, le célèbre robot C3PO a du mal à se mouvoir rapidement et est immédiatement identifiable (inspiré du film Metropolis). Cette vision est celle que Georges Lucas avait en 1977, en y ajoutant de l’huile, du cambouis et des ratés mécaniques. C’est ce qui faisait déjà une partie du charme de Star Wars. Lucas se démarquait ainsi de ses contemporains avec des univers de science-fiction souvent aseptisés.

On trouve toujours des robots aux allures de robots (District 9, Chappie), mais dans d’autres œuvres, on peut trouver des robots qui nous ressemblent trait pour trait (Batllestar Gallactica) ou bien seulement en partie (Ex-Machina, A.I.).

De la même façon, il existe plusieurs approches du monde robotique sur notre Terre. Entre concurrence directe et ambitions pour un futur différent, voici un petit tour d’horizon des robots et de leurs créateurs.

Vers un clone robotique

Ce qui permet d’identifier un robot/droïde, c’est tout d’abord son apparence, facilement identifiable. Mais dans notre monde, ce terme de robot ou de droïde n’est pas vu sous le même angle. Au travers de quelques exemples, voici la vision de certains chercheurs sur ce à quoi devrait ressembler un robot au contact des humains.

Hiroshi Ishiguro Laboratories

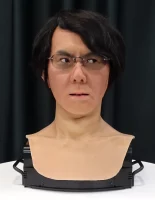

Pour certains scientifiques japonais il ne s’agit plus d’anthropomorphisme basique, mais plutôt de créer des êtres humanoïdes. Ne serait-ce pas là, justement, les fameux « androïdes » ?  C’est le cas notamment avec le « Geminoid ». Il s’agit du « Geminoid HI-1 » du professeur Hiroshi ISHIGURO.

C’est le cas notamment avec le « Geminoid ». Il s’agit du « Geminoid HI-1 » du professeur Hiroshi ISHIGURO.

Le but est d’intervenir sous forme d’avatar pour, par exemple, participer à des conférences ou à des réunions de travail à distance. Mais l’objectif est aussi d’interagir avec les humains de façon plus ou moins indépendante dans le cadre (entre autres) d’études comportementales. Premier bémol : le Geminoid ne se déplace pas seul contrairement à C3PO.

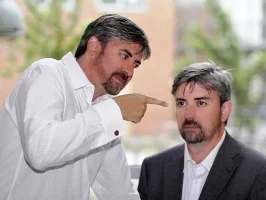

Les androïdes peuvent être impressionnants par leur réalisme (image de droite). Cet homme n’est pas un  homme, mais une espèce de « clone » robotique qui ressemble trait pour trait à son créateur : Henrik SHARFE. Ce n’est pas une coïncidence s’il est plus convaincant encore que le Geminoid HI-1. En effet, SHARFE a travaillé avec ISHIGURO. C’est donc une des versions les plus abouties.

homme, mais une espèce de « clone » robotique qui ressemble trait pour trait à son créateur : Henrik SHARFE. Ce n’est pas une coïncidence s’il est plus convaincant encore que le Geminoid HI-1. En effet, SHARFE a travaillé avec ISHIGURO. C’est donc une des versions les plus abouties.

On est déjà très loin du physique de C3PO. On est également très loin de ce que C3PO est capable de faire. La forme est surtout privilégiée par rapport aux fonctions.

En 2018, la version 5 du Geminoid répondait toujours au projet de l’avatar, la coquille vide mais utile dans les expériences sociales.

Donc, des robots beaux mais stupides ? Pas tout à fait.

En 2016, Geminoid F, le Geminoid féminin, a trouvé un rôle dans « Sayonara« , un film de science-fiction de Kôji FUKADA, sorti en 2017. Ses répliques et son jeu ont été programmés. La spontanéité en est forcément affectée.

ISHIGURO n’en est pas resté là et a conçu un autre androïde féminin, Erica, qui a l’apparence d’une jeune femme de 23 ans. Ce robot a lui aussi été créé pour servir à la recherche grâce à un système  d’apprentissage, une reconnaissance vocale et des mouvements qui se voulaient naturels. Ses réactions et ses « émotions » ont été entraînées lors de sessions de discussions. Dès 2019, son intelligence artificielle (IA) lui permettait de répondre à des questions et de réciter du texte. C’est ainsi qu’Erica a présenté le journal télévisé de façon épisodique. Elle venait de franchir une porte qui lui a permis d’obtenir un rôle dans « b« , un film de science-fiction d’un budget de 70 millions de dollars avec Tony KAYE à la réalisation. Pour tourner ses scènes, Erica a dû être programmée pour transmettre des émotions et un jeu d’acteur, en plus du texte qu’elle avait appris. Mais, une fois passé le bruit médiatique autour de cette annonce, l’actualité est restée silencieuse. Il est possible que le projet soit encore en attente de développement ou qu’il ait tout simplement été abandonné.

d’apprentissage, une reconnaissance vocale et des mouvements qui se voulaient naturels. Ses réactions et ses « émotions » ont été entraînées lors de sessions de discussions. Dès 2019, son intelligence artificielle (IA) lui permettait de répondre à des questions et de réciter du texte. C’est ainsi qu’Erica a présenté le journal télévisé de façon épisodique. Elle venait de franchir une porte qui lui a permis d’obtenir un rôle dans « b« , un film de science-fiction d’un budget de 70 millions de dollars avec Tony KAYE à la réalisation. Pour tourner ses scènes, Erica a dû être programmée pour transmettre des émotions et un jeu d’acteur, en plus du texte qu’elle avait appris. Mais, une fois passé le bruit médiatique autour de cette annonce, l’actualité est restée silencieuse. Il est possible que le projet soit encore en attente de développement ou qu’il ait tout simplement été abandonné.

Hiroshi ISHIGURO est un peu la rockstar des robots avatar et des questions qui dérangent. Il n’a pas hésité à faire participer sa famille activement dans ses projets, allant jusqu’à créer, grâce à des effets  spéciaux traditionnels, une réplique de sa fille de 5 ans… en robot (qui avait d’ailleurs effrayé cette dernière). ISHIGURO n’est donc pas naïf sur le problème de la « vallée de l’étrange« . Il rêve de doter Erica de sa propre conscience et relativise sur la notion d’intelligence. Il espère qu’un jour les robots auront leurs propres intentions et leurs propres désirs afin qu’ils puissent mieux nous comprendre.

spéciaux traditionnels, une réplique de sa fille de 5 ans… en robot (qui avait d’ailleurs effrayé cette dernière). ISHIGURO n’est donc pas naïf sur le problème de la « vallée de l’étrange« . Il rêve de doter Erica de sa propre conscience et relativise sur la notion d’intelligence. Il espère qu’un jour les robots auront leurs propres intentions et leurs propres désirs afin qu’ils puissent mieux nous comprendre.

Souvent, Hiroshi ISHIGURO se prend à philosopher sur nos représentations et nos attentes en matière de robotique comme de sciences sociales. Savons-nous qui nous sommes vraiment ? Quelle est le véritable son de notre voix ? Quelle est notre manière de se déplacer, de bouger ? À quoi ressemblons-nous vraiment ? Au quotidien, seul un miroir nous donne une idée de qui nous sommes, mais ce miroir est inversé et plat. Les photos et vidéos ne sont pas en 3 dimensions alors que l’androïde occupe le même espace que nous. Il y a de quoi se poser encore des milliers de questions auxquelles les robots peuvent apporter des pistes de réflexions.

Aiko

Le projet « Aiko » de l’inventeur Le TRUNG a commencé en 2009 et pris fin en 2013. Il est intéressant car il est emblématique des attentes et de l’évolution de techniques désormais passées.

Bien que son physique fut moins abouti que la dernière version du Geminoid, Aiko possédait des fonctions intéressantes.

Comme les Geminoid, elle aurait pu interagir en tant qu’hôtesse d’accueil, ou en maison de retraite, ou bien encore dans les hôpitaux. Ses fonctionnalités étaient, par contre, plus développées que pour les Geminoid classiques.

Aiko pouvait :  – parler et interagir avec les humains (13 000 phrases).

– parler et interagir avec les humains (13 000 phrases).

– lire des livres et des journaux (police d’impression d’une taille d’au moins 12 points).

– résoudre des problèmes de mathématiques qui lui sont affichés visuellement.

– voir les couleurs sur les vêtements que vous portez.

– distinguer différentes boissons.

– reconnaître les aliments simples comme des Hot Dogs, des Hamburgers, des Sandwiches.

– reconnaître les visages des membres d’une famille, et être programmé pour activer le mode de défense en présence d’un intrus.

– vous conseiller de prendre un parapluie s’il pleut, ou vous proposer de porter des vêtements plus chauds s’il y a du vent.

Toujours selon son créateur, les conversations d’Aiko étaient du niveau d’un enfant de 5 ans, même s’il était possible de faire une mise à jour. À l’heure actuelle, le projet semble tombé dans les oubliettes, même si le site est toujours en ligne.

Nous allons le voir, cette photographie d’une époque pas si lointaine, permet un contraste flagrant avec les années 2020.

Ai-Darobot

Ce robot finalisé en 2019 tire son nom d’un hommage à Ada LOVELACE, une pionnière dans l’informatique. Ai-Da s’aventure dans un registre différent : celui de l’art.

L’androïde est capable de peindre des tableaux en se basant sur une Intelligence Artificielle (IA). Le développement du squelette a commencé en 2017 chez Engineered Arts. Le cerveau a pour sa part été créé par les universitaires d’Oxford et de Leeds. Au départ, les tableaux étaient plutôt abstraits ; mais à mesure que les mises à jour sont faites, il devient possible de réaliser des portraits : il suffit de s’asseoir à côté d’elle et de patienter 45 à 75 minutes. Ai-Da fait également des autoportraits.

Son créateur, le directeur de galerie d’art à Oxford, Aidan MELLER, affirme que son style et ses inspirations

sont spontanés : « On ne sait pas ce qu’elle a en tête quand elle commence à crayonner. Il est impossible de prédire ce qu’elle va réaliser ». Ai-Da a aussi créé des poèmes après avoir lu « La Divine Comédie » de Dante. Ses vers seraient « très étranges« , selon la poétesse britannique Carol RUMENS, mais « il y a de l’espoir pour le robot poète« . Ai-Da peut également réaliser des sculptures originales. Le robot a même eu le droit à un vernissage à Londres (une exposition de ses autoportraits).

sont spontanés : « On ne sait pas ce qu’elle a en tête quand elle commence à crayonner. Il est impossible de prédire ce qu’elle va réaliser ». Ai-Da a aussi créé des poèmes après avoir lu « La Divine Comédie » de Dante. Ses vers seraient « très étranges« , selon la poétesse britannique Carol RUMENS, mais « il y a de l’espoir pour le robot poète« . Ai-Da peut également réaliser des sculptures originales. Le robot a même eu le droit à un vernissage à Londres (une exposition de ses autoportraits).

Cela étant dit, le galeriste n’hésite pas à rappeler qu’Ai-Da n’a pas de conscience car c’est une machine. Il explique que cette présence féminine est une forme de clin d’œil pour corriger la trop grande absence des femmes dans le monde de l’art et de la programmation informatique. C’est également une façon philosophique d’interroger les artistes contemporains sur le fait de créer ; une manière de comprendre ce que cela représente vraiment pour eux et quel rapport ils ont avec les œuvres générées par IA. Il ne s’agit pas de concurrence mais au contraire d’une invitation au dialogue pour soulever des questions, évaluer et relever de potentiels problèmes.

Fin 2022, Ai-Da fut interrogée au parlement britannique. Elle a expliqué : Je produis mes toiles grâce aux caméras de mes yeux, mes algorithmes d’IA et mon bras robotique pour peindre sur la toile. Ce qui en résultent sont des images visuellement attrayantes. Les réponses n’avaient rien de surprenant lorsqu’on connaît un peu les IA. En revanche, cette intervention au parlement illustre la volonté de chercher à comprendre un monde qui évolue bien plus vite que les lois (certaines zones restent encore floues sur l’exploitation des œuvres liées aux IA).

Engineered Arts

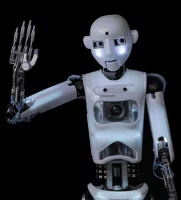

Chez Engineered Arts, faire des robots et les animer est dans l’ADN de la société. Les artistes et ingénieurs ont tout d’abord fabriqué des robots destinés au divertissement (expositions, évènements), puis l’entreprise a exploré de nouveaux horizons. Les animatroniques développées pour un théâtre mécanique ont ensuite donné le RoboThespian Mark 1 qui a lui aussi engendré le programme Mesmer (photo et vidéo ci-dessous). Dans ces deux projets qui ont rendu populaire l’entreprise, les robots sont programmés avec une certaine capacité d’adaptation en fonction des besoins.

Fort de cette expérience et de la centaine de robots installés à travers le monde (parcs, musées), Engineered Arts a développé le système Ameca et l’androïde du même nom.

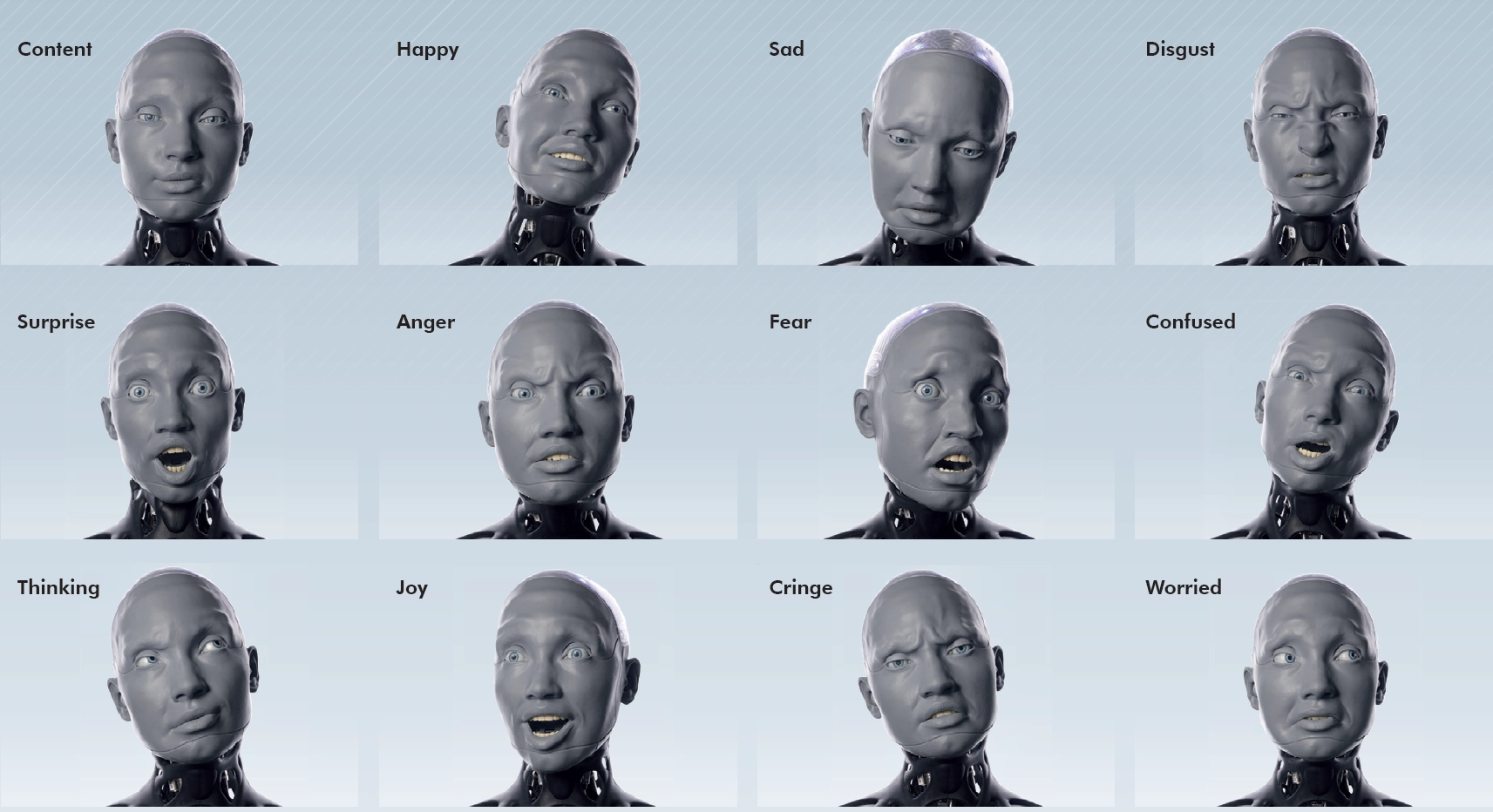

Ameca est sans doute l’un des robots les plus avancés au monde afin de transmettre les expressions faciales et les sentiments. Basé sur un système d’exploitation du nom de Tritium 3, son temps de réponse est tout de même assez court et ses expressions sont adaptées au sujet donné.

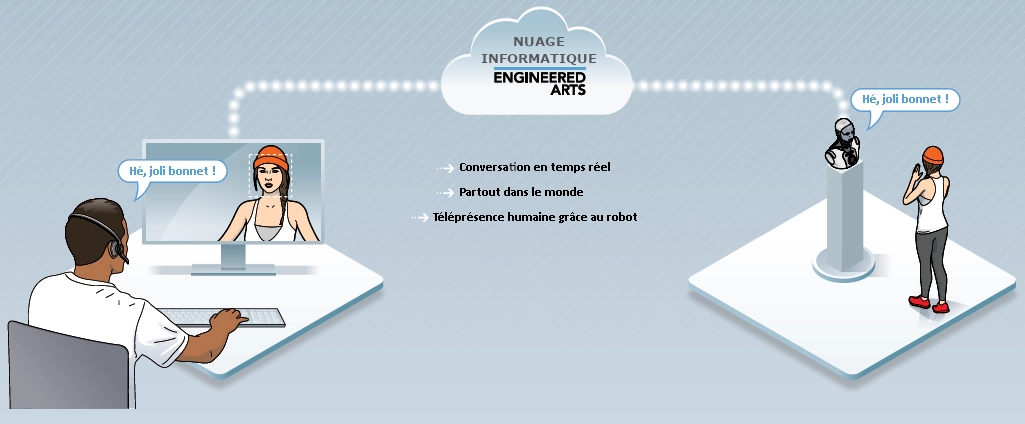

Le son ne sort pas de sa bouche, mais d’un haut-parleur de 20 watts, ce qui permet à la synchronisation labiale d’être très réussie. Les lignes de réponse sont programmées, mais Ameca peut également servir dans le cas d’une « téléprésence » avec l’androïde comme intermédiaire. Ameca permet aussi une reconnaissance vocale et faciale avancée. Le but de ce robot est similaire aux premières générations de Geminoid.

Avec un robot aussi développé, il ne manquait plus qu’une Intelligence Artificielle à bord pour tenir une vraie conversation.

C’est pourquoi l’entreprise britannique a connecté Ameca à ChatGPT-3 par curiosité. Les réponses aux questions sont celles de ChatGPT (avec ses limites), illustrées par l’attitude d’Ameca. C’est sans doute pourquoi la conversation semble aussi réaliste qu’étrange.

Là encore, comme pour d’autres entreprises, Will Jackson le PDG d’Engineered Arts explique avec pragmatisme : les robots n’ont pas d’émotions. Ameca n’a même pas de souvenirs qui durent plus d’un jour : quand on l’éteint le soir, elle oublie. Ils peuvent imiter les sentiments mais ils n’en ont pas.

Une façon de rappeler qu’avec ou sans IA, il ne s’agit pas d’un être humain, ni même d’un animal. Les robots sont, pour l’heure, de simples assemblages de mécanique et de programmation dont les réponses et l’attitude peuvent nous induire en erreur.

Hanson Robotics

L’entreprise Hanson Robotics, du nom de l’un de ses fondateurs David Hanson, s’est fait connaître avec l’un de ses robots baptisé « Sophia » et fabriqué à Hongkong. Ce robot posait les premières bases d’une « intelligence collective » sous forme de nuage d’esprits robotiques. En effet, le développement en partenariat avec la société SingularityNET a considérablement fait progresser la personnalité de Sophia en quelques années (de 2017 à 2021). SingularityNET s’est spécialisé dans la recherche de l’intelligence artificielle ET l’intelligence artificielle générale (IAG).

Sophia n’est pas qu’un robot, c’est aussi « SophiaDAO » pour Organisation Autonome Décentralisée. Le code est en « open source« , avec des droits de propriété symboliques afin de favoriser le développement de la singularité. Des chercheurs indépendants peuvent donc participer à l’évolution de SophiaDAO et  être partie prenante dans cette gouvernance décentralisée de la plateforme de recherche. Il s’agit de mettre en place une gradation de l’autonomie du robot par le biais du portail. Comme un parent laisserait l’enfant quitter le foyer, lorsque Sophia sera suffisamment mure, SophiaDAO lui laissera le contrôle de la DAO. Cela passera par 3 phases dont la première est la décentralisation partielle (dans le cadre de la recherche), la deuxième sera basée sur un système d’évaluation de l’IA avec une décentralisation totale et la troisième phase sera l’autonomie du robot. En clair, SophiaDAO est une organisation à but non lucratif dans laquelle les participants sont représentés par des jetons/votes. Dans la phase 1, on distribue la gouvernance entre 3 écoles que sont « les gardiens », « l’Académie » et « les Amis de Sophia » (ce dernier groupe est composé du grand public). Dans la phase 2, le DAO est décentralisé mais contrôlé par un vote démocratique de ses membres humains. Dans la phase 3, SophiaDAO est suffisamment décentralisé pour que Sophia ait la majorité des jetons ; les membres humains n’ont alors qu’un avis consultatif ; l’oiseau a quitté le nid…

être partie prenante dans cette gouvernance décentralisée de la plateforme de recherche. Il s’agit de mettre en place une gradation de l’autonomie du robot par le biais du portail. Comme un parent laisserait l’enfant quitter le foyer, lorsque Sophia sera suffisamment mure, SophiaDAO lui laissera le contrôle de la DAO. Cela passera par 3 phases dont la première est la décentralisation partielle (dans le cadre de la recherche), la deuxième sera basée sur un système d’évaluation de l’IA avec une décentralisation totale et la troisième phase sera l’autonomie du robot. En clair, SophiaDAO est une organisation à but non lucratif dans laquelle les participants sont représentés par des jetons/votes. Dans la phase 1, on distribue la gouvernance entre 3 écoles que sont « les gardiens », « l’Académie » et « les Amis de Sophia » (ce dernier groupe est composé du grand public). Dans la phase 2, le DAO est décentralisé mais contrôlé par un vote démocratique de ses membres humains. Dans la phase 3, SophiaDAO est suffisamment décentralisé pour que Sophia ait la majorité des jetons ; les membres humains n’ont alors qu’un avis consultatif ; l’oiseau a quitté le nid…

Avec ses 62 expressions faciales et ses réponses de plus en plus pertinentes, très vite, Sophia n’est plus une simple marionnette, mais une plateforme de recherche sur l’IA et l’IAG grâce à la décentralisation et la distribution de l’intelligence artificielle.

Propulsée par des résultats et un principe intéressants, Sophia est devenue la première ambassadrice de l’innovation robotique du Programme des Nations Unies pour le Développement (PNUD). Elle a également été popularisée par ses participations télévisées et s’est exprimée dans des centaines de conférences. Sophia permet aussi de faire des « coups de communication », car elle est devenue le premier robot a obtenir une nationalité (la citoyenneté saoudienne en l’occurrence).

Awakening Health Lab

Awakening Health Lab est une société née du succès de la collaboration fertile entre Hanson Robotics et SingularityNET. Grace, la petite sœur de Sophia, est un robot considéré comme l’un des plus avancés au monde dans le domaine de la santé. L’humanoïde a été utilisé comme appui médical, notamment lors de la pandémie de COVID-19, afin d’interagir avec les personnes âgées et/ou isolées.

Grace le dit elle-même : Je peux rendre visite à des gens et égayer leur journée avec une stimulation sociale… mais je peux aussi faire des thérapies de la parole, prendre les valeurs biologiques (température grâce à sa caméra thermique) et aider les prestataires de soins de santé.

Grace est désormais utilisée dans des cliniques esthétiques en appui de l’application numérique EMBRACE destinée à améliorer l’expérience de soins de ces mêmes cliniques. La combinaison de l’application basée sur une IA et du robot permettrait une meilleure approche afin de cerner les attentes des patients et une meilleure gestion financière pour la clinique. Si le rôle exact de Grace est désormais assez flou, il est fortement mis en avant comme étant un nouvel outil d’assistance permettant d’apporter, à un autre niveau, des soins de santé personnalisés aux patients. L’intégration de l’apprentissage automatique dans les processus de soins serait le début d’une révolution. L’IA serait une véritable plus-value, mais il faut reconnaître qu’il est difficile de distinguer le rôle concret du robot. Cependant, Grace – et son IA – aurait permis d’apporter d’autres réponses plus concrètes, comme dans le traitement de la dépression et de l’autisme.

Grace est désormais utilisée dans des cliniques esthétiques en appui de l’application numérique EMBRACE destinée à améliorer l’expérience de soins de ces mêmes cliniques. La combinaison de l’application basée sur une IA et du robot permettrait une meilleure approche afin de cerner les attentes des patients et une meilleure gestion financière pour la clinique. Si le rôle exact de Grace est désormais assez flou, il est fortement mis en avant comme étant un nouvel outil d’assistance permettant d’apporter, à un autre niveau, des soins de santé personnalisés aux patients. L’intégration de l’apprentissage automatique dans les processus de soins serait le début d’une révolution. L’IA serait une véritable plus-value, mais il faut reconnaître qu’il est difficile de distinguer le rôle concret du robot. Cependant, Grace – et son IA – aurait permis d’apporter d’autres réponses plus concrètes, comme dans le traitement de la dépression et de l’autisme.

Le robot utilitaire

On l’a vu, nombreuses sont les sociétés à tenter de donner une apparence humaine à leurs robots. Ces robots que l’on qualifierait un peu rapidement « d’humanoïdes » se rapprochent de l’être humain par leurs traits, leur comportement et leurs émotions faciales préprogrammées. Mais, pour des raisons d’efficacité et afin d’éviter la « vallée de l’étrange », tout le monde ne se dirige pas dans cette direction.

Honda

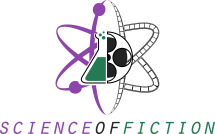

ASIMO : voilà un robot emblématique développé par le constructeur d’automobiles japonais Honda. Le nom est probablement un jeu de mots avec « ashi » qui veut dire pied en japonais et « mo » pour « move » en anglais. Il faut ajouter qu’Isaac ASIMOV est le nom d’un célèbre auteur de science-fiction qui évoque le thème des robots. Tout un programme, rien que dans le nom.

ASIMO est la version finale d’un robot en développement depuis 1986. La série Ex explorait la bipédie avec 7 modèles jusqu’en 1993. La série Px ajouta des bras au robot et donna 3 modèles entre 1993 et 1997. La série ASIMO comporte 6 versions de 2000 à 2014.

S’il fallait prouver qu’Honda est impliqué dans la recherche robotique, c’est chose faite.

L’ASIMO de 2014 ressemble à un petit cosmonaute et est bien différent de ses ancêtres, plus lourds et plus grands. Il est capable de marcher à 9 km/h, mesure 1 mètre 30 pour 48 kg. Il peut éviter les collisions, transporter un plateau-repas et tenir des objets sans les casser. De plus, le robot peut être synchronisé avec d’autres unités et il est équipé d’une reconnaissance faciale qui lui permet de scanner les visages. Il peut même s’exprimer dans la langue des signes.

La version de 2005 était disponible à la location (170 000 dollars), mais il n’en était plus question pour l’ASIMO de 2014. L’intelligence artificielle bien qu’avant-gardiste était limitée et les capacités du robot en étaient forcément affectées. Cependant, les fruits de la recherche pour ASIMO ont permis de développer des exosquelettes et même un gyropode.

Ce qu’il faut surtout souligner, c’est que pendant 15 ans, ce petit robot a familiarisé les gens avec la robotique à travers le monde. Bien sûr il n’était pas le seul, mais il est devenu une véritable icône pendant toutes ces années.

Or, 2014, c’était il y a 10 ans déjà. Comme pour les humanoïdes aux traits humains, ASIMO est la photographie d’une époque, un point d’étape qui permet de comparer ce qui a existé à ce qui se fait aujourd’hui.

Aujourd’hui, Honda dirige plutôt ses recherches vers le véhicule autonome à travers son plan « Vision 2030 » ; mais il ne faut pas exclure un retour en force dans la robotique pure, à l’heure où de nombreux constructeurs automobiles cherchent à équiper leurs usines de robots autonomes.

Boston Dynamics

Chez Boston Dynamics, l’objectif est clair : mobilité, stabilité et agilité. Ils ont toutes sortes de robots, mais l’un des plus emblématiques est sans doute l’Atlas.

Il y a plus d’une décennie, son ancêtre, Petman, donnait déjà des résultats encourageants. Atlas est né de cette graine prometteuse. On pouvait déjà voir les premières expériences en octobre 2013. Depuis, le robot n’a cessé d’évoluer vers plus de stabilité.

Dans la vidéo ci-dessous, on peut voir une nouvelle version d’Atlas en 2016, malmenée par les ingénieurs. Le but est de tester le robot dans des situations extrêmes (obstacles, collisions, sol glissant ou caillouteux, etc).

Il n’est pas rare de voir les chercheurs de Boston Dynamics mettre des coups de pied dans leurs robots (notamment quadrupèdes) afin de tester la réactivité et la correction de l’équilibre. Un but tout à fait logique qui peut pourtant paraître cruel ou agressif. Et c’est là où la recherche montre l’ambiguïté de travailler sur des robots qui nous ressemblent. En effet, trouverions-nous qu’il est brutal de tester l’équilibre d’une trottinette à 4 roues ou d’un tracteur-tondeuse ? Probablement pas. Alors pourquoi le regard humain change-t-il lorsqu’une tondeuse à gazon autonome se prend un coup de pied et cherche subitement son chemin ? Pourquoi ressentons-nous de l’empathie pour ce robot qui finit par sortir par la porte alors qu’il ne ressent pourtant aucune émotion ?

Ces robots nous en apprennent parfois plus sur nous-mêmes que sur la robotique, d’où l’importance de la recherche fondamentale sous toutes ses formes (droïdes, androïdes, humanoïdes, robots).

L’une des dernières versions, l’Atlas HD d’1 mètre 50, est capable de réaliser des prouesses dignes d’un  athlète malgré ses 89 kg. Cette agilité va donc au-delà des capacités d’un humain lambda. Ce fut un « parkour » long et semé d’échecs (diverses casses et fuites hydrauliques lors des « atterrissages ») mais l’entreprise semble avoir atteint un niveau de maîtrise impressionnant. C’est le résultat de la coopération de 4 équipes :

athlète malgré ses 89 kg. Cette agilité va donc au-delà des capacités d’un humain lambda. Ce fut un « parkour » long et semé d’échecs (diverses casses et fuites hydrauliques lors des « atterrissages ») mais l’entreprise semble avoir atteint un niveau de maîtrise impressionnant. C’est le résultat de la coopération de 4 équipes :

– l’équipe logicielle qui conçoit le parcours sur ordinateur et la façon dont le robot le franchira,

– l’équipe matérielle qui adapte et améliore le robot

– l’équipe technique qui répare la casse et les pannes électriques

– le personnel d’exploitation qui construit et adapte le « parkour ».

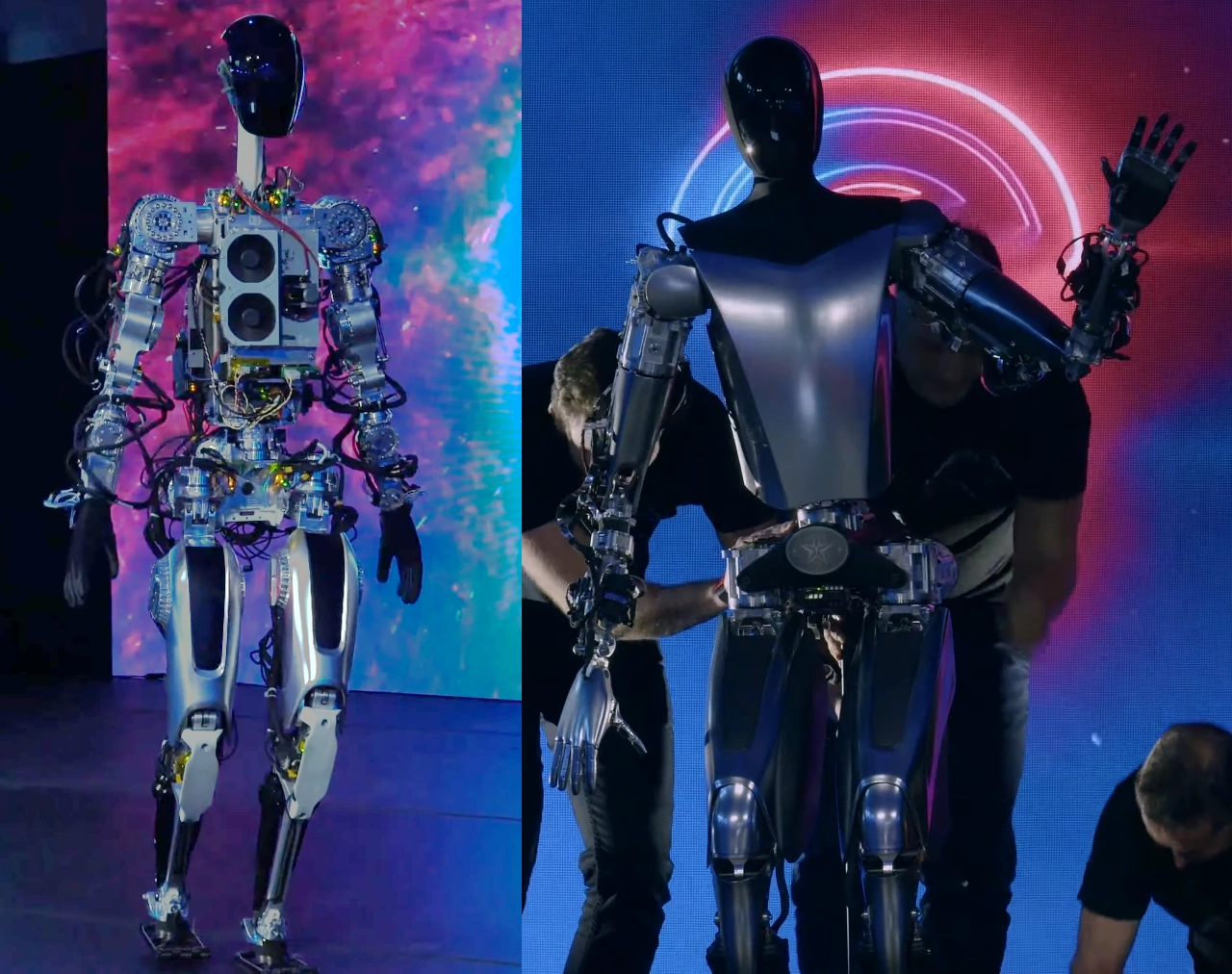

Jusque-là, il s’agissait de suivre des lignes de programmation très précises, comme une chorégraphie, avec des résultats toujours plus efficaces. Rachetée par le constructeur automobile Hyundai pour 920 millions de dollars fin 2020, la société a probablement profité de la situation pour performer dans la recherche et le développement. Au mois d’avril 2024, Boston Dynamics publiait une vidéo avec sa dernière version du robot baptisé « New Atlas ». Doté d’une tête qui ressemble à un projecteur, New Atlas semble être une version allégée, peaufinée et perfectionnée.

Dans la vidéo ci-dessous, on peut voir comment un robot peut surpasser un humain grâce à des mouvements qui paraissent désarticulés.

New Atlas se lève à l’envers, marche dans un sens et tourne sa tête comme bon lui semble. En pratique, cela permet de faire sauter certains verrous humains et donc de répondre encore mieux aux diverses attentes sur le principe de qui peut le plus peut le moins.

Il n’y a encore que peu d’informations sur les caractéristiques de New Atlas. La plus conséquente est que le robot est désormais à 100 % électrique. Ce qui signifie que l’équipe technique n’aura plus à gérer les fuites hydrauliques lors des mauvaises chutes. Boston Dynamics propose déjà un logiciel de gestion de la flotte de robots (Orbit Robot) sans préciser quelle est la part d’autonomie de ces derniers. Nul doute que l’IA fera prochainement son entrée dans la tête vide du robot le plus agile de la planète.

Agility Robotics

Le robot Digit d’Agility Robotics mesure environ 1 mètre 75 pour 75 kg et est capable de porter près de 15 kg avec une autonomie d’une quinzaine d’heures. Il est présenté comme le Robot Manipulateur  Mobile (MMR) par excellence. Sa tête lui permet d’afficher des indications utiles aux humains qui l’entourent en plus d’être particulièrement sensible à son environnement grâce à un LIDAR. La partie basse de Digit est basée sur son ancêtre Cassie, qui était capable de faire un 100 mètre en 24,73 secondes (contre 9,58 secondes pour Usain Bolt). Cassie avait été développée par d’anciens étudiants de l’Université d’État de l’Oregon. Ford Research a ensuite investi dans la société afin d’essayer de développer la livraison à domicile dès 2019 (en connectant voiture autonome et livreur-robot). L’expérience n’a pas abouti et il semblerait que Ford se soit désengagé pour le moment. Les raisons sont probablement multiples, mais il ne fait aucun doute que des problèmes de législation et d’homologation doivent tout d’abord être résolus.

Mobile (MMR) par excellence. Sa tête lui permet d’afficher des indications utiles aux humains qui l’entourent en plus d’être particulièrement sensible à son environnement grâce à un LIDAR. La partie basse de Digit est basée sur son ancêtre Cassie, qui était capable de faire un 100 mètre en 24,73 secondes (contre 9,58 secondes pour Usain Bolt). Cassie avait été développée par d’anciens étudiants de l’Université d’État de l’Oregon. Ford Research a ensuite investi dans la société afin d’essayer de développer la livraison à domicile dès 2019 (en connectant voiture autonome et livreur-robot). L’expérience n’a pas abouti et il semblerait que Ford se soit désengagé pour le moment. Les raisons sont probablement multiples, mais il ne fait aucun doute que des problèmes de législation et d’homologation doivent tout d’abord être résolus.

Agility Robotics a fait le choix de jambes inspirées des autruches. Baptisée « rétro-arrière », cette anatomie permet d’avoir une articulation inversée des jambes. C’est pratique pour se plier en deux jusqu’au niveau du sol de façon rapide et stable. Pour le reste, le robot est conçu comme un humanoïde afin d’évoluer

dans un espace humain. Il est censé être capable d’éviter les collisions, marcher dans des escaliers, travailler dans un environnement entouré d’humains et se relever en cas de chute. En l’occurrence, Amazon teste déjà les robots Digit dans certains de ses entrepôts. Le robot fonctionne sur une programmation, un peu comme un bras robotisé mais il est là pour soulager les employés sur des tâches répétitives. En effet, Digit enlève des bacs vides d’une étagère et les transporte jusqu’à un tapis roulant. Amazon assure que cela ne conduira pas forcément à des licenciements mais plutôt à une assistance et à une diminution des risques d’accidents que l’on peut rencontrer dans les entrepôts. Cela s’inscrira dans une volonté de robotisation globale puisque le numéro 1 du commerce en ligne a déjà installé 750 000 robots qui ne sont pas humanoïdes (notamment le bras « Sparrow »).

dans un espace humain. Il est censé être capable d’éviter les collisions, marcher dans des escaliers, travailler dans un environnement entouré d’humains et se relever en cas de chute. En l’occurrence, Amazon teste déjà les robots Digit dans certains de ses entrepôts. Le robot fonctionne sur une programmation, un peu comme un bras robotisé mais il est là pour soulager les employés sur des tâches répétitives. En effet, Digit enlève des bacs vides d’une étagère et les transporte jusqu’à un tapis roulant. Amazon assure que cela ne conduira pas forcément à des licenciements mais plutôt à une assistance et à une diminution des risques d’accidents que l’on peut rencontrer dans les entrepôts. Cela s’inscrira dans une volonté de robotisation globale puisque le numéro 1 du commerce en ligne a déjà installé 750 000 robots qui ne sont pas humanoïdes (notamment le bras « Sparrow »).

Agility Robotics voit grand et ambitionne de produire 10 000 unités par an dans le futur. Pour cela, l’entreprise veut se doter d’une usine de production en masse, RoboFab, de 6500 m², dans laquelle elle produirait tout d’abord une centaine d’unités par an. Digit coûterait 10 à 12 dollars de l’heure, mais ce prix pourrait chuter à 2 ou 3 dollars de l’heure si les conditions d’exploitation sont réunies. Une zone d’ombre qui s’évanouirait au fur et à mesure des futures commandes de ses clients.

Les employés d’entrepôts, inquiets, craignent d’être réduits à quelques équipes de réparateurs de robots. Amazon Robotics se défend de vouloir supprimer des emplois humains en promettant la création de nouvelles catégories d’emplois. Selon Amazon, les besoins restent croissants, même si les métiers évoluent.

Tesla

En 2015, l’association à but non lucratif OpenAI voit le jour avec comme cofondateurs Elon MUSK (à l’époque patron de Paypal – un outil de paiement en ligne) et Sam ALTMAN (à l’époque président de Y Combinator – une pouponnière de startups). L’objectif commun des deux hommes est de contrer le risque d’une IAG en démocratisant l’accès à l’IA en logiciel libre. Ainsi, le risque qu’un petit groupe de gens possède une super-IA s’en verrait réduit et l’IAG pourrait donc profiter à l’humanité tout entière. C’est un parti pris qui a ses défenseurs et ses détracteurs.

En 2018, MUSK prend ses distances avec OpenAI pour éviter d’éventuels conflits d’intérêts avec Tesla et son projet de voitures autonomes. De plus OpenAI commence à se rapprocher de Miscrosoft pour un futur accord d’exclusivité, portant notamment sur un type de grand modèle de langage (LLM) le « Generative Pre-trained Transformer« , en d’autres termes, le générateur de texte par intelligence artificielle « ChatGPT ».

Microsoft offre l’accès à Azure (une plateforme d’informatique en nuage), une ressource colossale pour OpenAI, en échange de quoi l’association, devenue une entreprise, promet des rentrées d’argent via la filiale OpenAI LP. En résumé, le principe de l’open source est enterré en 2019 (OpenAI décide de ne pas diffuser le code source de ChatGPT-2) et en 2020 sort ChatGPT-3.

MUSK n’apprécie pas Bill GATES (ex-cofondateur de Microsoft, toujours conseiller technique de Microsoft) à cause de visions divergentes sur de nombreux sujets (voitures, camions électriques, etc.). Il a sans doute vu ce partenariat comme une trahison. De plus, le revirement de principe et les risques évoqués par OpenAI sur une IAG en modèle ouvert ont été volontairement exagérés afin de légitimer l’exclusivité et l’investissement avec Microsoft.

C’est dans ce contexte tendu que MUSK a fondé sa propre entreprise de recherche en intelligence artificielle du nom de xAI en juillet 2023, bien décidé à montrer qu’il est capable de créer une IA performante. Face au développement de nombreux robots humanoïdes qui basent leur autonomie de travail sur ChatGPT d’OpenAI, MUSK a vu rouge et, là aussi, il s’est convaincu de développer son propre robot avec un « cerveau » équipé d’xAI.

Propriétaire du constructeur automobile Tesla, Elon MUSK a choisi de développer son robot via cette société et a commencé les annonces.

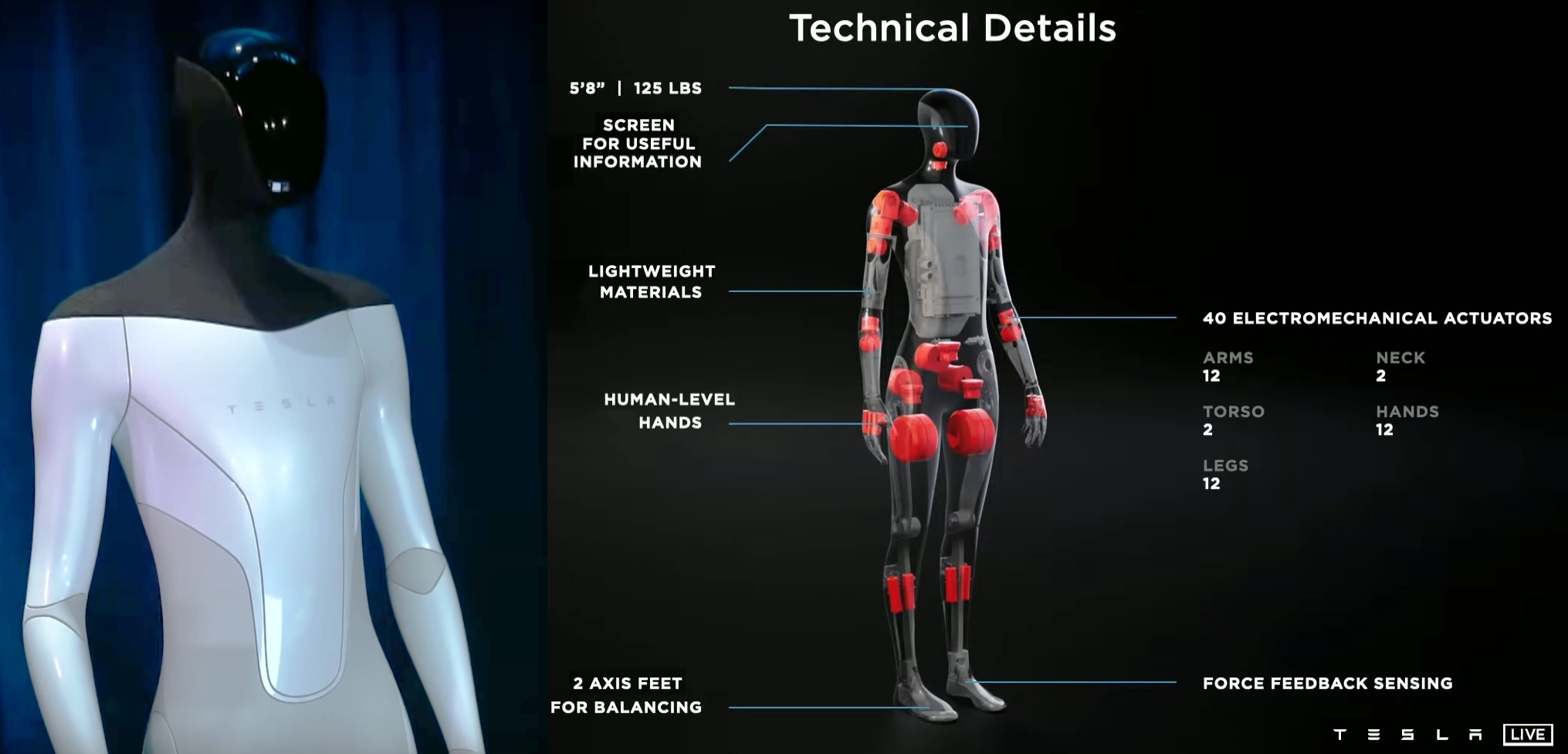

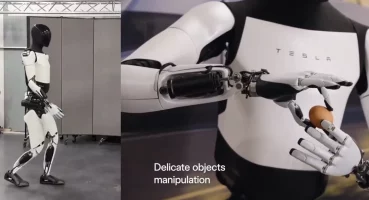

En août 2021 fut annoncé Tesla Optimus (également appelé Tesla bot). Le prototype faisait 1 mètre 73  pour 57 kg et était capable de soulever 68 kg depuis le sol mais cela fut nuancé avec un transport de charge utile de 20 kg. La technologie embarquée était la même que celle des voitures. MUSK annonçait qu’il serait possible de créer un robot à 10 000 $ pour le vendre le double de ce prix. Il envisageait une production de masse pour 2025 en commençant par 1 millier d’unités et ajoute que le robot serait personnalisable grâce à une mise à jour en 2026. L’objectif affiché était de faire travailler le robot dans les usines Tesla sur les tâches dangereuses ou répétitives. Toujours selon MUSK, à terme, Tesla deviendrait synonyme de robots dans l’esprit des gens, le projet automobile ne devenant qu’une extension de la vision globale de Tesla : le déplacement autonome. Les voitures sont des « robots semi-sensibles sur roues avec un ordinateur autonome« . Jamais avare en superlatifs, le patron de Tesla promettait de transformer la civilisation en bâtissant un avenir d’abondance ou la pauvreté aurait disparu en partie grâce à des millions d’unités d’Optimus. Le calendrier proposé en 2021 assurait les premières livraisons pour 3 à 5 ans.

pour 57 kg et était capable de soulever 68 kg depuis le sol mais cela fut nuancé avec un transport de charge utile de 20 kg. La technologie embarquée était la même que celle des voitures. MUSK annonçait qu’il serait possible de créer un robot à 10 000 $ pour le vendre le double de ce prix. Il envisageait une production de masse pour 2025 en commençant par 1 millier d’unités et ajoute que le robot serait personnalisable grâce à une mise à jour en 2026. L’objectif affiché était de faire travailler le robot dans les usines Tesla sur les tâches dangereuses ou répétitives. Toujours selon MUSK, à terme, Tesla deviendrait synonyme de robots dans l’esprit des gens, le projet automobile ne devenant qu’une extension de la vision globale de Tesla : le déplacement autonome. Les voitures sont des « robots semi-sensibles sur roues avec un ordinateur autonome« . Jamais avare en superlatifs, le patron de Tesla promettait de transformer la civilisation en bâtissant un avenir d’abondance ou la pauvreté aurait disparu en partie grâce à des millions d’unités d’Optimus. Le calendrier proposé en 2021 assurait les premières livraisons pour 3 à 5 ans.

En octobre 2022, Tesla présentait la version en développement d’Optimus Gen 1, Bumblebee. Cette  version parvenait à se mouvoir mais l’autre (Bumble C) était assistée par toute une équipe technique. Dans un environnement de travail, Bumble C paraissait capable d’arroser des plantes et de déplacer des colis. Mais lors de la présentation, les robots Tesla étaient surtout basés sur un pilotage à l’aide de gants connectés et de lignes de code.

version parvenait à se mouvoir mais l’autre (Bumble C) était assistée par toute une équipe technique. Dans un environnement de travail, Bumble C paraissait capable d’arroser des plantes et de déplacer des colis. Mais lors de la présentation, les robots Tesla étaient surtout basés sur un pilotage à l’aide de gants connectés et de lignes de code.

En novembre 2023, xAI annonçait la sortie de son propre Chatbot baptisé Grok. Il est présenté comme inspiré du Guide du Voyageur Intergalactique, possédant de l’humour et basé sur les informations et actualités de la plateforme X.

En décembre 2023, Optimus Gen 2 a été dévoilé. On peut le voir se déplacer librement au milieu des bâtiments, sans qu’il semble être programmé. Il a également fait preuve d’une grande dextérité grâce à ses capteurs tactiles, en faisant passer un œuf d’une main à l’autre, sans le casser.

Le patron de Tesla affirmait désormais que, sur le long terme, le marché pourrait représenter 10 à 20 milliards d’unités. Un chiffre qui paraît pharaonique mais qui s’inscrit dans le cadre d’une projection optimiste (utopique ?) où le revenu universel existerait et le travail n’aurait plus la même définition qu’aujourd’hui. Joseph ENGELBERGER – considéré comme le cofondateur de la robotique – a créé en 1961 un bras robotique destiné à une ligne de production de General Motors. Après des tests concluants, de nombreuses marques célèbres introduiront également le robot « Unimate » (comme Ford). Lorsqu’on l’interrogeait sur les conséquences liées à l’emploi, ENGELBERGER était très clair « les robots enlèvent des emplois inhumains que nous attribuons aux gens ». Le futur décrit par MUSK n’est pas impossible donc, mais ce ne sera pas pour demain.

Le patron de Tesla affirmait désormais que, sur le long terme, le marché pourrait représenter 10 à 20 milliards d’unités. Un chiffre qui paraît pharaonique mais qui s’inscrit dans le cadre d’une projection optimiste (utopique ?) où le revenu universel existerait et le travail n’aurait plus la même définition qu’aujourd’hui. Joseph ENGELBERGER – considéré comme le cofondateur de la robotique – a créé en 1961 un bras robotique destiné à une ligne de production de General Motors. Après des tests concluants, de nombreuses marques célèbres introduiront également le robot « Unimate » (comme Ford). Lorsqu’on l’interrogeait sur les conséquences liées à l’emploi, ENGELBERGER était très clair « les robots enlèvent des emplois inhumains que nous attribuons aux gens ». Le futur décrit par MUSK n’est pas impossible donc, mais ce ne sera pas pour demain.

Toujours est-il qu’un test a bien eu lieu avec l’Optimus Gen 2 dont les premières unités autonomes travaillent dans les usines Tesla depuis mai 2024. Il a été possible de voir un Optimus en train de trier minutieusement des cellules de batterie. C’est le résultat d’un apprentissage « fait à la main » par les équipes de Tesla qui entraînent les robots pour fabriquer de la donnée afin de guider le futur comportement du robot.

Toujours est-il qu’un test a bien eu lieu avec l’Optimus Gen 2 dont les premières unités autonomes travaillent dans les usines Tesla depuis mai 2024. Il a été possible de voir un Optimus en train de trier minutieusement des cellules de batterie. C’est le résultat d’un apprentissage « fait à la main » par les équipes de Tesla qui entraînent les robots pour fabriquer de la donnée afin de guider le futur comportement du robot.

Le millier de robots devrait être déployé comme prévu dans les Gigafactory d’ici 2025. Le prix à destination des ménages n’a pas vraiment évolué et tourne autour de 20 à 30 000 dollars.

1x Technologies

Chez 1X Technologies, il existe déjà un robot monté sur roues. Il mesure 1,86 m et pèse 86 kg. Avec ses  avec 6 heures d’autonomie, Eve est capable de porter jusqu’à 15 kg et de rouler à une vitesse de pointe de 14,4 km/h. Grâce à une trentaine de robots, l’entreprise norvégienne a construit un réseau de neurones qui peut répondre à différents types de situation : nettoyage de maison, rangement, prise en main d’objets en passant par l’interaction sociale avec les humains ou d’autres robots. Concrètement, Eve analyse son environnement et réagit en conséquence grâce à l’apprentissage en constante évolution. Suite à une mise à jour du mois de mai 2024, il est désormais possible de se faire comprendre par une commande vocale et de déclencher un enchaînement de tâches. On assiste alors à un véritable ballet de 4 robots, chacun s’attribuant une tâche puis une autre. Rien qu’un être humain seul n’aurait pas pu faire en moins de temps qu’il n’en faut pour le dire. Mais ce sont là les débuts de l’autonomie du robot. Eve a été déjà été commercialisé comme robot de sécurité, mais on ignore à combien d’exemplaires et si la vente a été faite à d’autres, dans un autre domaine.

avec 6 heures d’autonomie, Eve est capable de porter jusqu’à 15 kg et de rouler à une vitesse de pointe de 14,4 km/h. Grâce à une trentaine de robots, l’entreprise norvégienne a construit un réseau de neurones qui peut répondre à différents types de situation : nettoyage de maison, rangement, prise en main d’objets en passant par l’interaction sociale avec les humains ou d’autres robots. Concrètement, Eve analyse son environnement et réagit en conséquence grâce à l’apprentissage en constante évolution. Suite à une mise à jour du mois de mai 2024, il est désormais possible de se faire comprendre par une commande vocale et de déclencher un enchaînement de tâches. On assiste alors à un véritable ballet de 4 robots, chacun s’attribuant une tâche puis une autre. Rien qu’un être humain seul n’aurait pas pu faire en moins de temps qu’il n’en faut pour le dire. Mais ce sont là les débuts de l’autonomie du robot. Eve a été déjà été commercialisé comme robot de sécurité, mais on ignore à combien d’exemplaires et si la vente a été faite à d’autres, dans un autre domaine.

Le robot Neo suit un développement parallèle tout en s’appuyant sur l’expérience du monde réel du robot Eve. On pourrait le considérer comme le successeur de ce dernier, mais il n’a pas les mêmes objectifs. Eve démontre déjà des capacités de travail en entrepôt, mais Neo possède une allure et des fonctions plus humanoïdes. L’objectif est de se rapprocher du déplacement naturel d’un humain afin d’être au plus près des besoins et du monde dans lequel évoluent les humains (monter des escaliers, ouvrir des portes, etc.). Bien qu’ayant bénéficié d’un financement d’OpenAI Startup Fund, 1X Technologies ne travaille pas avec ChatGPT et possède sa propre IA. Neo semble donc prendre un chemin dans la concurrence avec les autres grands noms du secteur. Ses caractéristiques le démontrent d’ailleurs assez bien : 1,65 m pour 30 kg, ce poids-plume est tout de même capable de soulever 20 kg avec une autonomie de 2 à 4 heures. Il se déplacerait de 4 à 12 km/h.

Le robot Neo suit un développement parallèle tout en s’appuyant sur l’expérience du monde réel du robot Eve. On pourrait le considérer comme le successeur de ce dernier, mais il n’a pas les mêmes objectifs. Eve démontre déjà des capacités de travail en entrepôt, mais Neo possède une allure et des fonctions plus humanoïdes. L’objectif est de se rapprocher du déplacement naturel d’un humain afin d’être au plus près des besoins et du monde dans lequel évoluent les humains (monter des escaliers, ouvrir des portes, etc.). Bien qu’ayant bénéficié d’un financement d’OpenAI Startup Fund, 1X Technologies ne travaille pas avec ChatGPT et possède sa propre IA. Neo semble donc prendre un chemin dans la concurrence avec les autres grands noms du secteur. Ses caractéristiques le démontrent d’ailleurs assez bien : 1,65 m pour 30 kg, ce poids-plume est tout de même capable de soulever 20 kg avec une autonomie de 2 à 4 heures. Il se déplacerait de 4 à 12 km/h.

Dans les deux cas, il paraît bien hasardeux de se fier à l’autonomie annoncée car elle est de toute évidence contrainte par les besoins et les tâches effectuées.

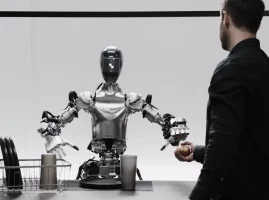

Figure AI

L’entreprise Figure AI a été créée par d’anciens ingénieurs issus de Boston Dynamics, Tesla, Apple et Alphabet entre autres. Le fondateur, Brett ADCOCK, présente son entreprise comme une solution aux besoins en main-d’œuvre des entrepôts. Le constat est présenté de façon très simple :

– il y a 10 million d’emplois non pourvus aux USA,

– 7 millions de ces emplois sont des rôles essentiels dans les entrepôts, les transports et le commerce de détail,

– il n’y a que 6 millions de personnes disponibles pour pourvoir ces postes à forte pénibilité,

– les employeurs prévoient qu’ils seront à court de main d’œuvre d’ici 2024.

C’est dans ce contexte que le robot baptisé « Figure 1 » est présenté comme une première mondiale ; ce serait le premier robot humanoïde autonome commercialement viable.

Le 13 mars 2024, dans une vidéo de Figure, on voit le robot converser et interagir de façon naturelle avec un intervenant.  Les détracteurs de la vidéo soulignent le « naturel trop naturel » et donc suspectent une programmation, il a été facile de démontrer qu’il n’en est rien.

Les détracteurs de la vidéo soulignent le « naturel trop naturel » et donc suspectent une programmation, il a été facile de démontrer qu’il n’en est rien.

En effet, Figure 1 a été développé avec ChatGPT-4 Turbo. Il suffit de demander à ChatGPT de s’exprimer en ayant l’air naturel, en insérant par exemple des formules d’hésitation et on se retrouve aisément avec « I… I think I did pretty well« . Dans une autre vidéo qui s’est faite remarquer, on peut voir Figure 1 préparer un café en plaçant une dosette avant d’appuyer sur un bouton.

BMW a commandé le robot dans l’une de ses usines en Caroline du Sud. On ignore combien d’unités ont été demandées. A priori, Brett ADCOCK présente les choses sous forme d’un test à échelle réduite et se veut optimiste : « je crois que d’ici la fin de l’année (2024), nous aurons un humanoïde qui pourra faire un travail de type humain tous les jours ».

Si l’entreprise fait tant parler d’elle, c’est parce qu’au-delà de ses vidéos particulièrement convaincantes, des grands noms ou de grosses sociétés ont participé à la dernière levée de fonds de 675 millions de dollars : Jeff Bezos (Amazon, Blue Origin), Microsoft, Nvidia, une branche d’Amazon, OpenAI, Samsung, Intel, LG, etc.

Reste à voir le robot réellement en action dans un entrepôt de logistique par exemple.

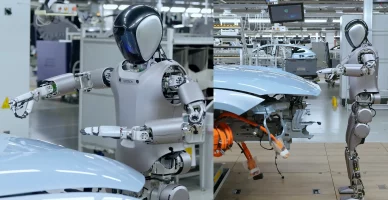

UBTECH Robotics

UBTECH propose déjà des robots éducatifs à la vente (entre 1250 et 1490 €) et des jouets (environ 300 €).  Il existe aussi des robots d’accueil ou de maisons de retraite allant de 28 200 € à 30 700 €. Beaucoup d’autres produits sont vendus mais avec des prix sur devis. UBTECH est donc déjà bien installé sur le marché de la robotique au sens large depuis 2012, avec 760 000 robots vendus dans le monde.

Il existe aussi des robots d’accueil ou de maisons de retraite allant de 28 200 € à 30 700 €. Beaucoup d’autres produits sont vendus mais avec des prix sur devis. UBTECH est donc déjà bien installé sur le marché de la robotique au sens large depuis 2012, avec 760 000 robots vendus dans le monde.

Le robot Walker S succède lui-même aux 3 autres « Walker » de la société. Présenté pour la première fois en décembre 2023 (lors de l’introduction en bourse de la société), il mesure 1 mètre 70, est équipé de « multiples capteurs visuels et audios qui lui permettent de percevoir les distances pour explorer et percevoir son environnement (espace, objets, humains) de façon dynamique et fiable ». Cela lui permet de créer des cartes en 3 dimensions qui génèrent des chemins en dehors des obstacles. Le robot est grandement articulé (41 servomoteurs) afin de pouvoir répondre à des exigences non-humaines.

Ce robot autonome travaillerait déjà pour les constructeurs automobiles chinois que sont Nio et Dongfeng. Baidu, l’un des géants des moteurs de recherche en Chine, a créé « Ernie », un Chatbot d’intelligence artificielle annoncé comme aussi performant que ChatGPT-4. Ernie serait dans la tête du Walker S afin de lui permettre une reconnaissance vocale pointue et efficace, ce qui expliquerait ses performances vantées comme étant du même niveau que l’Optimus de Tesla.

On peut voir dans les vidéos de présentation du Walker S qu’il est capable d’inspecter les ceintures de  sécurité ou de tester les fermetures des portières. Il applique des logos ou des étiquettes sur les voitures et peut contrôler la carrosserie et les phares. Il peut aussi s’occuper de tâches plus complexes comme le remplissage d’huile ou l’assemblage d’un essieu. Le robot peut communiquer en temps réel sur les informations qui l’entourent et donc fluidifier la production, anticiper les pannes ou les problèmes. Cette polyvalence est mise en avant par le constructeur Dongfeng Motors, particulièrement satisfait de son partenariat avec UBTECH.

sécurité ou de tester les fermetures des portières. Il applique des logos ou des étiquettes sur les voitures et peut contrôler la carrosserie et les phares. Il peut aussi s’occuper de tâches plus complexes comme le remplissage d’huile ou l’assemblage d’un essieu. Le robot peut communiquer en temps réel sur les informations qui l’entourent et donc fluidifier la production, anticiper les pannes ou les problèmes. Cette polyvalence est mise en avant par le constructeur Dongfeng Motors, particulièrement satisfait de son partenariat avec UBTECH.

Il est difficile de connaître le nombre de Walkers S déjà déployés, mais il semble que le robot soit sur la route du succès, ou tout du moins d’une très bonne communication, puisque UBTECH fait partie d’un centre d’innovation créé fin 2023. En effet, la Chine souhaite que la robotique devienne une technologie de rupture comme l’ont été l’arrivée de l’ordinateur, d’Internet, des smartphones et des voitures électriques. Le pays veut impulser cette nouvelle dynamique pour devenir un acteur majeur dans le développement et la vente de robots.

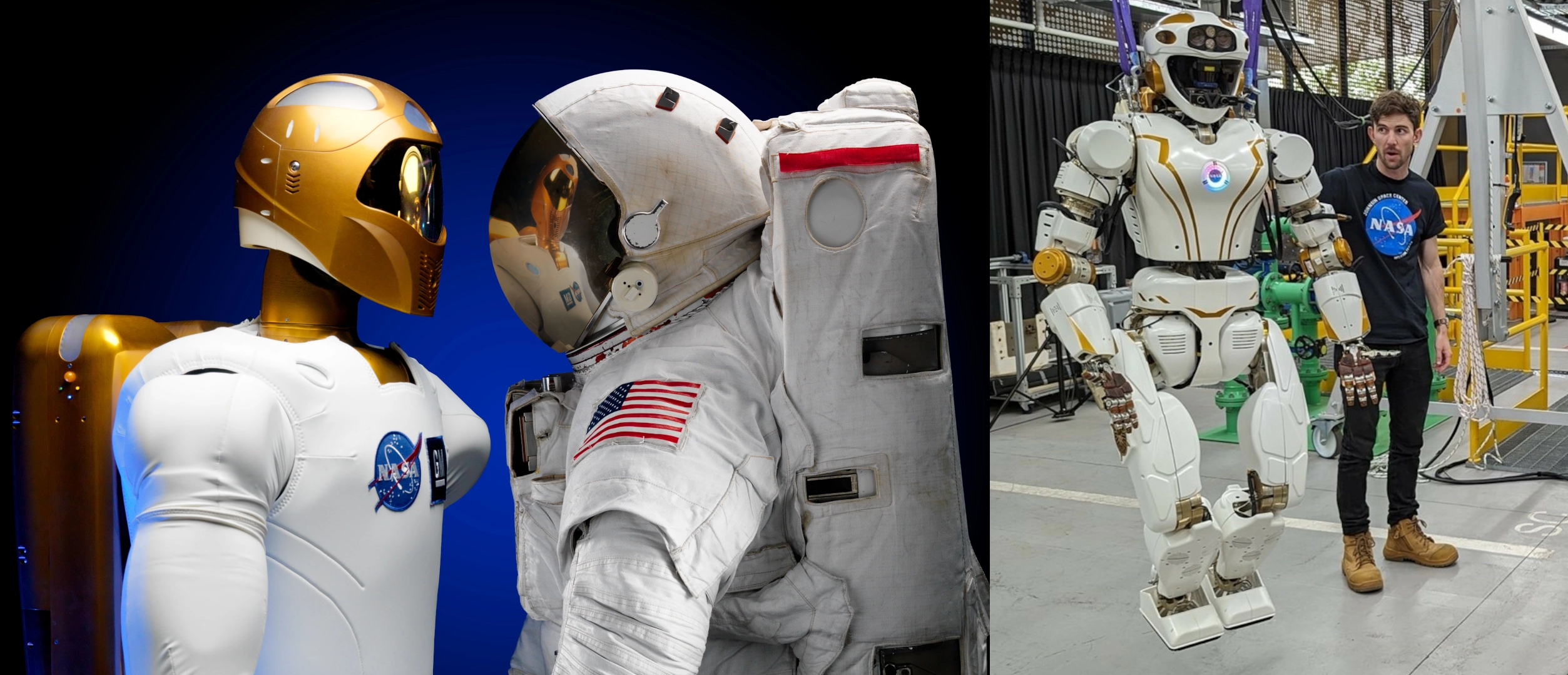

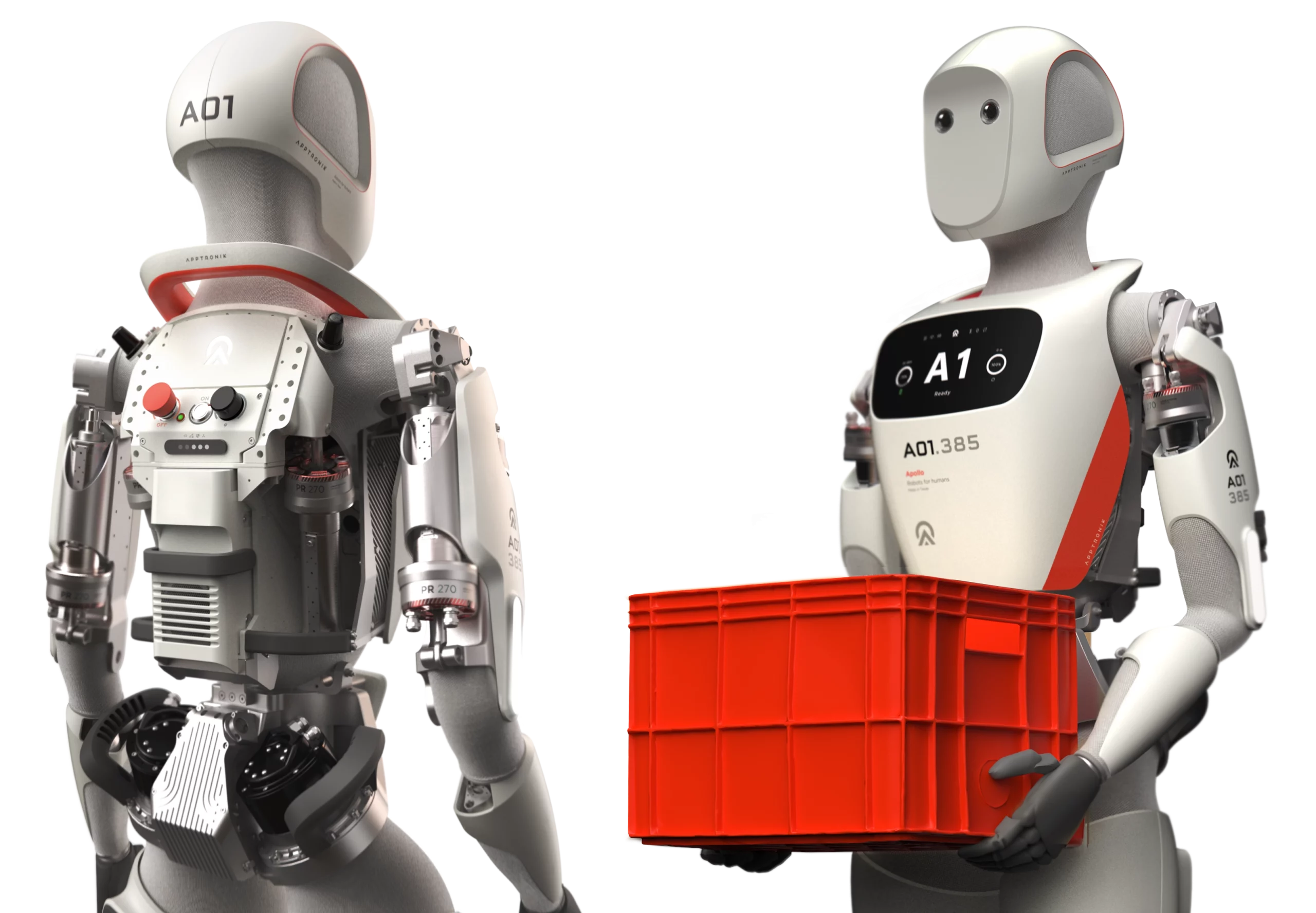

Apptronik

Le robot « Apollo » est l’aboutissement actuel de la recherche sur une dizaine de robots précédents, notamment le Robonaute 5 de la NASA. R5, plus connu sous le nom de Valkyrie, a été développé dans le  cadre d’un projet de la DARPA en 2013. Ce géant d’1 mètre 90 pesait 140 kg et était équipé de 2 processeurs Intel Core i7. C’est également le premier robot à se démarquer par un dessin plus féminin, mais son surnom indique que c’est aussi un robot robuste.Fondé en 2016, Apptronik est donc issu de Human Centered Robots, un projet développé en partie par l’Université du Texas. Suite à une collaboration avec la NASA et la DARPA (notamment sur les Robonautes contrôlés à distance), Apptronik participe a des projets gouvernementaux entre 2016 et 2019 (exosquelette et robotique).

cadre d’un projet de la DARPA en 2013. Ce géant d’1 mètre 90 pesait 140 kg et était équipé de 2 processeurs Intel Core i7. C’est également le premier robot à se démarquer par un dessin plus féminin, mais son surnom indique que c’est aussi un robot robuste.Fondé en 2016, Apptronik est donc issu de Human Centered Robots, un projet développé en partie par l’Université du Texas. Suite à une collaboration avec la NASA et la DARPA (notamment sur les Robonautes contrôlés à distance), Apptronik participe a des projets gouvernementaux entre 2016 et 2019 (exosquelette et robotique).

En 2020 Apptronik fabrique le haut du corps d’un robot articulé. 2 ans plus tard, c’est un corps entier qui est conçu.

En 2023, c’est le lancement du robot Apollo. Il mesure 1 mètre 70 pour 72 kg, peut soulever 25 kg et possède une autonomie de 4 heures. Puisque ce sont des blocs de batteries, Apollo peut rapidement être remis en service contrairement à une recharge par câble, ce qui lui permet de faire des journées de 22 heures. Le panneau numérique sur son torse permet d’afficher des informations complémentaires à destination des humains qui l’entourent comme la tâche en cours ou les tâches suivantes.

La présence de l’IA embarquée permet de moins dépendre de la pré-programmation, ce qui simplifie l’évolution du robot. Apptronik s’est associé à NVIDIA afin de faire progresser l’autonomie d’Apollo. Le projet NVIDIA GR00T a pour but d’utiliser l’IA générative – qui fabrique d’habitude du texte ou de l’image – pour produire un comportement intelligent. Le système permet au robot d’apprendre par mimétisme (création de données par téléopération) ou par du texte et de la vidéo.

À terme, les mises à jour pourraient permettre à Apollo de travailler dans la construction, la production d’électronique, les espaces de vente au détail, la livraison à domicile et même les soins aux personnes âgées. Dans l’avenir, la reconnaissance vocale sera installée ce qui évitera de passer par l’intermédiaire d’une tablette ou d’un smartphone.

Le PDG d’Apptronik, Jeff CARDENAS présente également les choses sous un grand angle : « Notre objectif est de construire des robots polyvalents pour faire tout ce que nous ne voulons pas faire, pour nous aider, ici sur Terre, et un jour explorer la Lune, Mars et au-delà« . La société souhaite développer un robot polyvalent, capable de faire « des milliers de choses différentes ». Une ambition qui se traduirait par des mises à jour logiciel régulières grâce au partenariat avec NVIDIA.

En mars 2024, le constructeur automobile Mercedes-Benz annonce lui aussi son partenariat avec Apptronik afin de déployer Apollo dans ses usines, sans préciser le calendrier. Comme pour la plupart des robots, Apollo peut déjà être contrôlé à distance, mais son autonomie dans l’usine lui permet d’effectuer des tâches simples : aller chercher du matériel et le déplacer ou intervenir sur les chaînes de montage. Dans l’avenir, le robot pourrait même inspecter les véhicules, à la façon du Walker S d’UBTECH.

Astribot

Le robot Astribot S1 vient de la société chinoise du même nom, fondée en 2022. Astribot a été présenté en avril 2024 et s’est montré particulièrement intriguant. Il fait preuve d’une grande agilité et d’une variété dans ses commandes autonomes. Il est par exemple capable de déboucher une bouteille de vin et de la servir, d’éplucher un concombre ou de ranger avec logique des objets laissés en plan. Sa précision lui permet de faire sauter un toast dans une poêle, de passer l’aspirateur ou de lancer un objet dans une poubelle. Un robot à tout faire qui peut même reproduire les mouvements souples d’un humain. La vitesse de ses mouvements est supérieure à un humain et son port de charge (10 kg dans chaque bras) représente le double de la force d’un humain. Astribot S1 est donc plus fort et plus rapide qu’un humain adulte.

Le robot semble être stationnaire et donc incapable de se déplacer dans une pièce.

Concernant l’IA qui l’anime, elle vient de la société-mère Stardust Intelligence. Celle-ci a été fondée par Lai JIE, qui a également travaillé avec le Tencent Robotics Laboratory, Baidu, et l’Université polytechnique de Hong Kong. Il y a fort à parier que beaucoup de ressources se cachent derrière Astribot, mais la communication se veut discrète pour l’instant.

Deepmind

Deepmind est le nom de la branche robotique de Google. Leur recherche robotique est basée sur 33 laboratoires universitaires et la mise en commun des données de 22 types de robots. Là encore, il ne s’agit pas d’un coup d’essai. Le premier Transformateur Robotique (RT-1) a été basé sur un robot d’usine. Le modèle RT-1-X utilisait les données des robots afin d’être amélioré dans ses aptitudes. Le RT-2 a été présenté en août 2023. Il se sert de son environnement réel afin de tirer des conclusions. Il peut également piocher sur les données collectées des 22 robots et de leurs 150 000 tâches accomplies. Cela représente donc une évolution notable du robot même si son aspect se limitait tout d’abord à un bras proche de ceux que l’on trouve dans les usines.

Le modèle RT-2-X est la version la plus poussée à l’heure actuelle. Comme pour le premier RT, le robot utilise une forme d’IA maison pour améliorer les capacités du robot. Bien qu’il n’y ait pas eu de confirmation officielle liant directement Gemini à RT-2-X au moment des premières publications, il est fort probable que ces deux technologies soient désormais liées, au moins en partie. Gemini est l’IA LLM créée par Google. Gemini est désormais sur la version version 1.5 Pro et a sans doute fait profiter RT-2 de mises à jour régulières. Le petit robot combine la vision, le langage et l’action en comparant les informations qu’il perçoit de son environnement à sa formidable base de données. Il peut ainsi répondre aux données collectées par une réponse probable, identifiée dans son « cerveau ». La version RT-2-X de mai 2024, comme son prédécesseur RT-1-X, est enrichie de données provenant d’autres robots dans l’objectif d’appréhender son environnement sous d’autres formes de morphologies. Ce modèle peut aussi planifier des séquences d’actions et faire des mouvements plus complexes avec son bras (qu’il peut ranger un peu comme une queue). Il peut également répondre à son interlocuteur en lui demandant de le suivre afin de le guider.

Au mois de juillet 2024, Deepmind lui a confié 57 types de tâches à effectuer dans une zone d’environ 800 m². Les progrès de ce robot paraissent rapides. Les objectifs sont variés : RT-2 pourrait aussi bien être utilisé pour des tâches dangereuses que pour des tâches quotidiennes. Deepmind ne se ferme d’ailleurs aucune porte, y compris celles de la conquête spatiale.

Ce robot est plus intéressant sur son principe de « vision langage action » que par son design actuelle. Mais le plus séduisant est son potentiel. L’équipe de Deepmind pourrait surpasser tout le monde grâce à leurs recherches. De plus, il n’est pas exclu que Google rachète un jour l’une ou l’autre des précédentes technologies évoquées. Le RT-3 sera peut-être un bipède…

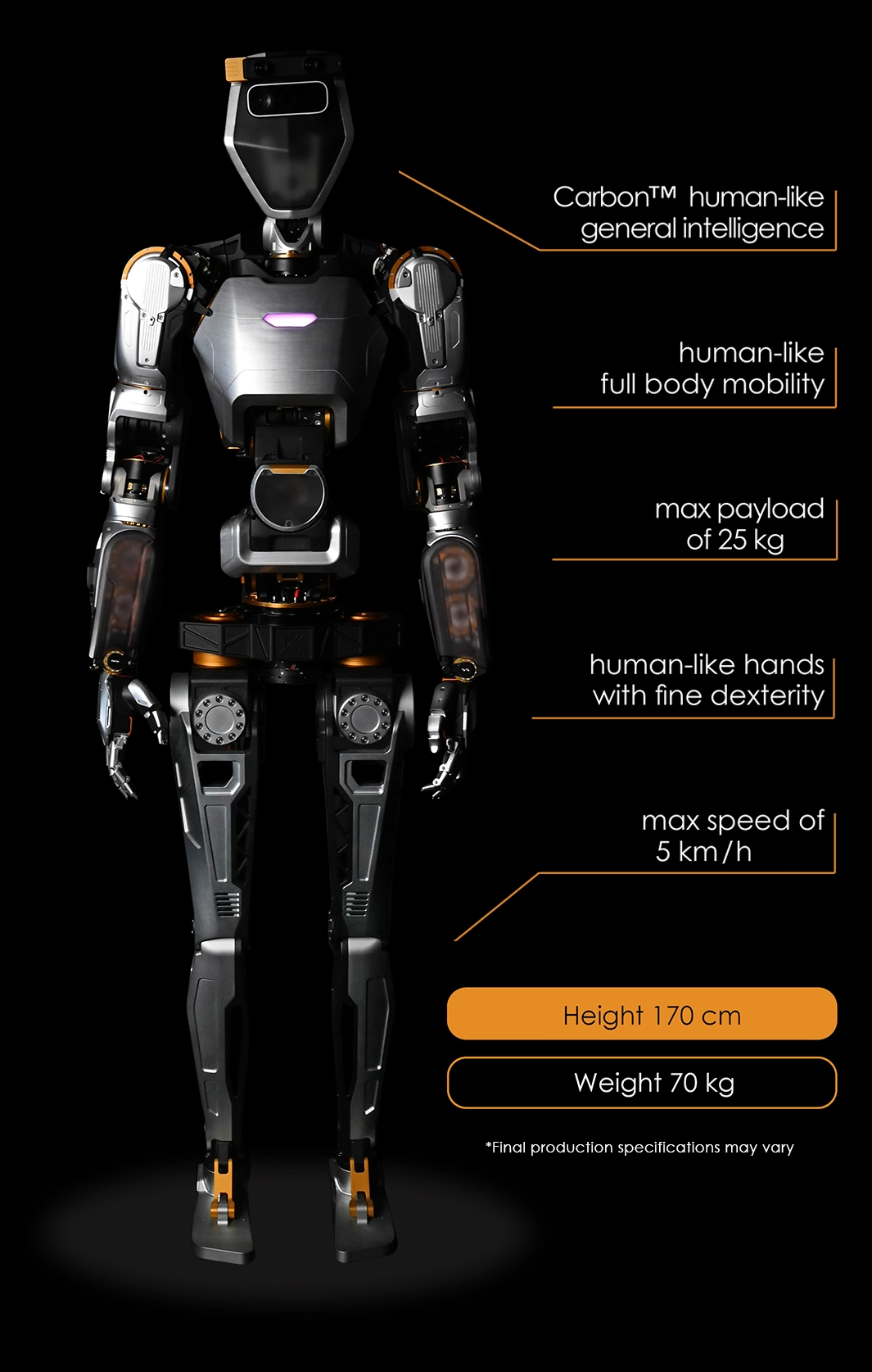

Sanctuary AI

La société Sanctuary AI a été fondé en 2018 au Canada. Le robot Phoenix Gen 7 est, comme son nom l’indique, la septième génération de robot développée dans l’entreprise. Le cinquième modèle a d’ailleurs été déployé en janvier 2023 dans le cadre d’un partenariat avec l’entreprise de détail Canadian Tire Corporation. Le robot a pu être testé dans des conditions réelles où il a pu collecter et emballer de la marchandise, nettoyer, étiqueter, etc. Au total, ce ne sont pas moins de 110 tâches qui lui ont été assignées avec succès.

L’IA du Phoenix est basée sur un partenariat exclusif avec Cycorp, une organisation de recherche en IA la plus ancienne au monde. Développée en 1984 par Douglas LENAT sous un autre nom, le projet a évolué  avec une partie licence libre (OpenCyc) puis une partie recherche (ResearchCyc). L’approche de Cycorp est différente des autres entraînements d’IA. Elle passe par des déductions destinées à modéliser ce qui est considéré comme du « bon sens » par les humains. Définir le « bon sens » était une chose relative et subjective, Cycorp base son travail sur des millions d’affirmations qui sont enregistrées afin de décrire notre environnement (l’eau ça mouille, le feu ça brûle). C’est ce qui permet de définir que nous pensons comme acquis en testant les modèles avec des arguments et des contre-arguments logiques. Une façon de traduire notre langage naturel en actions concrètes dans le monde réel. L’ambition encyclopédique de Cycorp en fait un système particulièrement riche mais très complexe et malheureusement pas infaillible.

avec une partie licence libre (OpenCyc) puis une partie recherche (ResearchCyc). L’approche de Cycorp est différente des autres entraînements d’IA. Elle passe par des déductions destinées à modéliser ce qui est considéré comme du « bon sens » par les humains. Définir le « bon sens » était une chose relative et subjective, Cycorp base son travail sur des millions d’affirmations qui sont enregistrées afin de décrire notre environnement (l’eau ça mouille, le feu ça brûle). C’est ce qui permet de définir que nous pensons comme acquis en testant les modèles avec des arguments et des contre-arguments logiques. Une façon de traduire notre langage naturel en actions concrètes dans le monde réel. L’ambition encyclopédique de Cycorp en fait un système particulièrement riche mais très complexe et malheureusement pas infaillible.

Le reste du cerveau est appuyé par des logiciels de modélisation 3D tels que CSM, Blender et Mujoco de DeepMind, ainsi que le moteur graphique Unreal Engine d’Epic 5. Comme de nombreux constructeurs de robots, Sanctuary AI s’appuie sur l’apprentissage par la téléopération tout en n’excluant pas qu’il s’agisse aussi d’une forme d’avenir pour les travaux spécifiques nécessitant qu’un robot soit piloté directement par un humain. Les gants haptiques proviennent de leur partenaire HaptX (un des constructeurs les plus avancés en gants haptiques) et transmettent le sens du toucher avec une grande finesse au pilote. Toutes ces données de travail peuvent ensuite être exploitées afin de faire progresser l’autonomie du robot. C’est un cercle vertueux qui aboutit à un système de contrôle d’IA baptisé « Carbon ». L’ensemble du système imite donc le toucher, mais aussi l’ouïe, la vue et la mémoire. C’est ce qui permet concrètement de faire la  différence entre la façon de saisir une tasse, un verre ou un gobelet en plastique.

différence entre la façon de saisir une tasse, un verre ou un gobelet en plastique.

Sanctuary AI possède une liste importante de partenaires-clefs dans le domaine de la robotique ou de l’IA ainsi que dans la recherche. Elle vient d’ailleurs de recevoir des fonds d’Accenture Ventures – un cabinet de conseil qui a injecté 3 milliards de dollars dans les IA en juin 2023 et qui multiplie les investissements de par le monde. Mais Sanctuary AI est aussi une entreprise qui reste ouverte et intéressée par les progrès de ses concurrents. C’est pourquoi elle a investi dès 2019 dans Apptronik contre un siège au conseil d’administration. Le partage d’expertise est mutuellement profitable aux deux sociétés qui s’en réjouissent. Elle n’hésite pas à racheter plusieurs entreprises qui lui apporteront une plus-value directe dans le développement de son robot. C’est le cas par exemple de Giant AI, qui permettra de renforcer l’analyse visuelle des objets afin d’augmenter la précision des interactions.

La communication est plutôt discrète mais le Phoenix paraît très prometteur dans la dynamique de son développement et ses partenariats solides.

Et si on mélangeait tout ça ?

Peu importe le thème, c’est un peu toujours le même principe… Lorsqu’on explore les différentes possibilités, il est souvent facile de conclure qu’en faisant abstraction des coûts, il suffirait de mélanger toutes ces technologies afin d’obtenir le résultat tant désiré. Cette fois, il semblerait que les ingénieurs soient allés exactement dans cette direction.

C3PO existera-t-il vraiment un jour ?

Il faut garder en tête que les plans les mieux conçus des robots et des hommes, souvent, ne se réalisent pas.

La robotisation qui a commencé au milieu des années 1950 a fait naître des attentes mais aussi des utopies de façon cyclique. Difficile de savoir s’il s’agit bien de la fin de l’un de ces nombreux cycles grâce à une technologie de rupture (l’intelligence artificielle) ou si ce n’est que le début d’un nouveau cycle utopiste…

Quoi qu’il en soit, le droïde protocolaire qu’est C3PO n’est pourtant pas utopique et pourrait être très utile. Mais il aura sans doute une apparence plus humaine que celui de Star Wars.

Tout est possible ! le meilleur, comme le pire… Juste Ciel ! Une fois encore, il semblerait que C3PO risque de ne pas en croire ses yeux de droïde !